近日,公司呼德研究员课题组与大连理工大学殷福亮教授团队合作在国际顶级期刊《IEEE Transactions on Intelligent Transportation Systems》上发表了题目为“Acoustic SLAM with Moving Sound Event based on Auxiliary Microphone Arrays”(DOI: 10.1109/TITS.2023.3289324)的论文。

即时定位与地图构建(Simultaneous Localization and Mapping, SLAM)在机器人探索未知环境时扮演着重要的角色。目前,基于视觉信息的SLAM方法已很成熟,并有大量产品实际应用。然而,在光线不足的环境中,视觉SLAM的性能将显著下降。为此,本文提出一种声学SLAM(ASLAM)新方法,利用机器人的听觉系统探索其周围声场,同时定位(跟踪)机器人本身及环境中的声源。

图1 室内环境中的ASLAM示意图

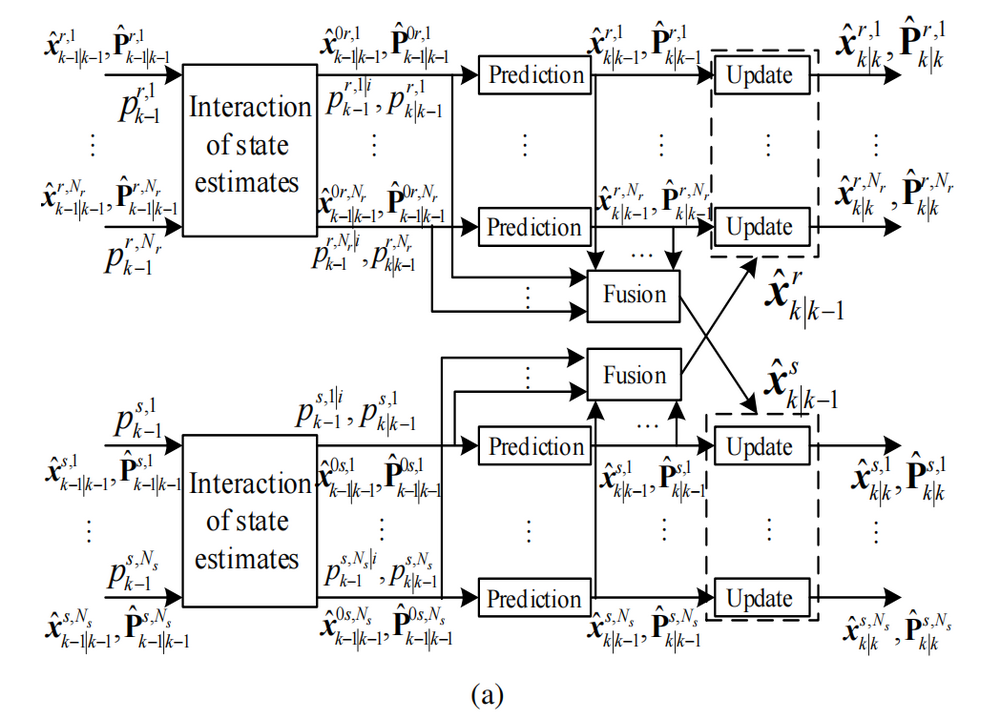

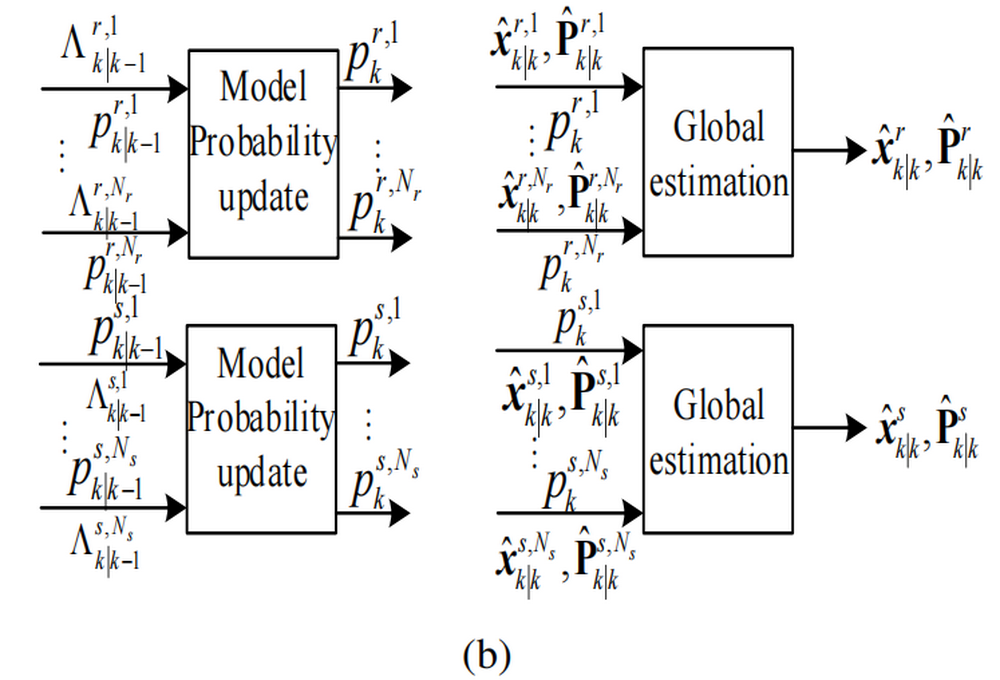

首先,本文给出一种ASLAM框架,首次实现了机器人和声源同时移动时的ASLAM任务。其次,本文提出一种双通道卡尔曼滤波器,分别用于实时估计机器人的位姿和声源的位置,它比传统的卡尔曼滤波器更能节省计算量,进而满足算法的实时性。最后,引入交互多模型(Interacting multiple models, IMM)对机器人和声源的运动状态进行建模,进一步提高了定位和定向精度。

图2 算法框架图

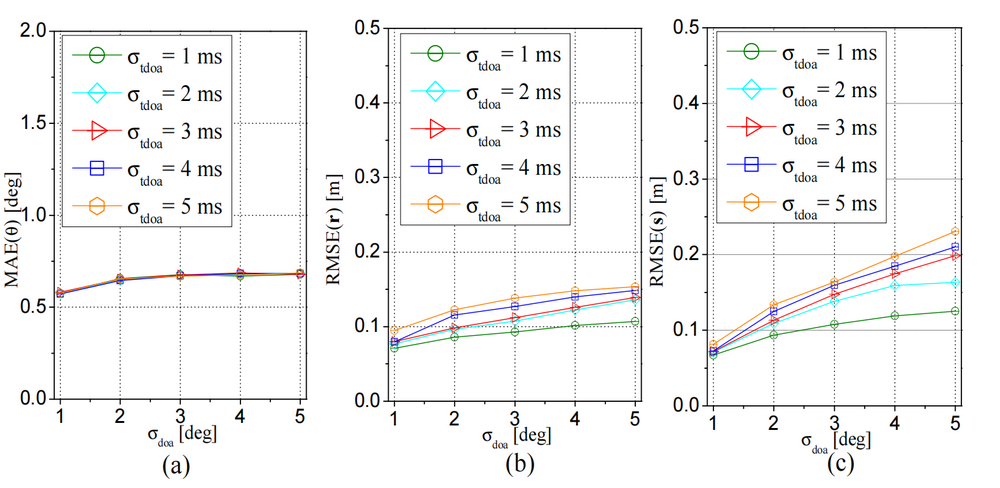

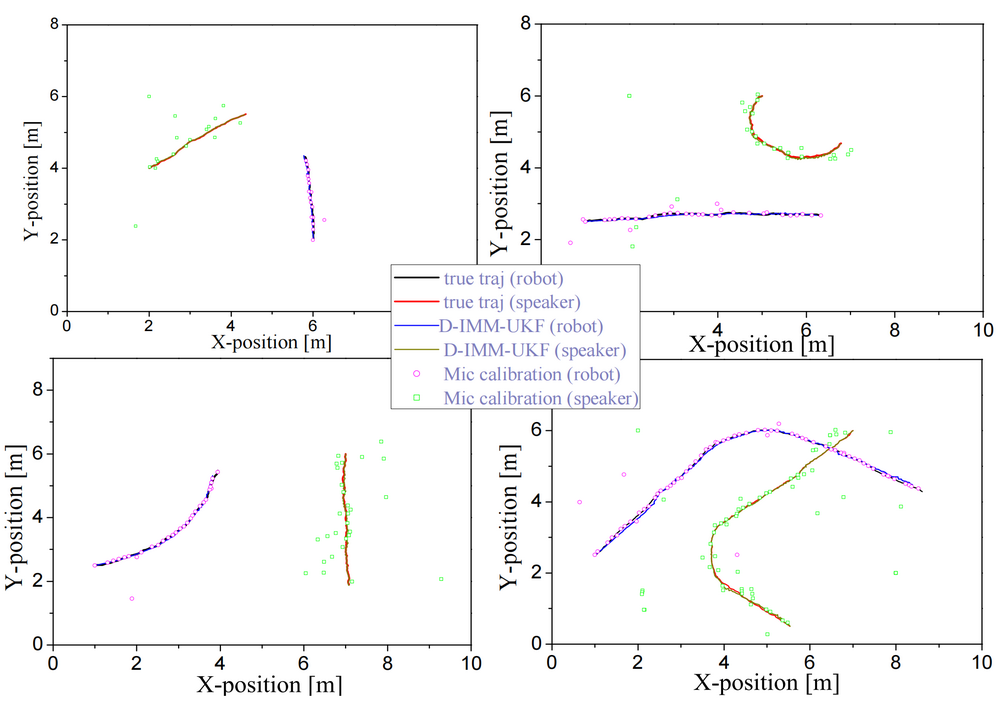

为了验证所提方法的有效性,论文进行了大量的仿真实验和实际实验。图3表明,所提方法在不同测量误差条件下均能精准地估计机器人和声源的位姿信息。图4则更直观地给出了所提算法的定位结果。此外,该算法也具备和传统视觉SLAM有效结合的潜力,有望实现音视频SLAM。

图3 不同测量误差条件下的定位、定向性能

图4 四种运动轨迹下的跟踪结果

《IEEE Transactions on Intelligent Transportation Systems》是智能交通领域国际顶级期刊,被列为JCR一区TOP期刊,影响因子为8.5。公司呼德研究员为该论文的第一作者,太阳成集团tyc33455cc为第一单位,该课题受到国家自然科学基金与太阳成集团tyc33455cc骏马计划资助。

论文链接:https://ieeexplore.ieee.org/document/10173709